L’évaluation : le problème de la formation

Vous connaissez sans doute le triangle pédagogique. Il explique très simplement que, dans tout processus de formation, doivent être cohérents :

- Les objectifs pédagogiques : quels contenus ? quelles typologies de compétences visées ?

- Les moyens pédagogiques : quelles activités ? quels supports ?

- L’évaluation : quelles modalités ? quelles questions ?

Autrement dit, on ne fait pas de formation si on n’a pas identifié les compétences qu’on veut développer. On s’arrange pour effectivement créer une formation qui les développe. Puis on évalue que lesdites compétences ont bien été acquises.

Logique ?

Mais, par rapport aux deux premiers piliers, pas de chance pour l’évaluation : on n’en prend pas beaucoup soin…

J’ai plusieurs théories sur les raisons de cet abandon :

- La formation est l’aspirine de l’entreprise. On l’utilise pour tout et n’importe quoi : team building, récompense, punition, justificatif, outil de communication, … mais pas assez souvent pour développer des compétences. Du coup, à quoi bon les évaluer ?

- Stratégiquement, évaluer est un risque. Imaginez que, en fait, les gens n’apprennent rien… C’est mal vu pour les participants … mais aussi pour les RH !

- Alors qu’elle devrait être prévue dès le début, l’évaluation est souvent envisagée à la fin du process de formation… Or, la formation prend déjà beaucoup de ressources (temporelles, financières, matérielles, humaines). On prend plaisir à s’interroger sur ses modalités : organisation en présentiel, en e-learning, en mooc, en serious gaming, avec des techniques ludo-pédagogiques, des classes inversées, du project based learning, etc etc etc ? Et pour l’évaluation qui arrive à la fin du process, en fait, on n’a ni le temps, ni l’argent et, franchement, on a un peu la flemme. [Et je ne parle même pas de la mesure d’impact de formation…]

- L’évaluation c’est un peu le petit gars qu’on sous-évalue dans une baston : on pense qu’on peut se le faire facilement, alors qu’en réalité il est méchamment balèze. Du coup, on s’en préoccupe peu puisque « c’est facile« . [Tiens, s’il faut 60% de moyenne et 50% minimum dans chacun des cours pour devenir détective privé, un étudiant qui obtient 48% de moyenne est-il forcément un mauvais détective ? et 58% ? Et un étudiant qui a obtenu 60% est-il forcément un bon détective ? Et 62% ? ]

Les modules d’évaluation : des solutions « à peu près »

Le paradoxe de l’évaluation :

Peu d’investissement VS donnée essentielle pour le reporting

C’est pour remplir ces 2 besoins opposés, l’allocation de faibles ressources et la génération de datas, que les outils de formation à distance ont généralement intégré un module de questionnement. [Bon, on a mis des notes à des gens, mais ne demandez quand même pas d’analyser ces données et de les lier à une stratégie long terme… ‘faut pas exagérer.]

Ainsi, tous les LMS (Learning Management System), tels que Moodle, Claroline, Blackboard ou encore Google Classroom, et autres e-learning ont leur outil d’examen. Certains très simples (upload de fichier par les étudiants, remise de note et commentaire par le.la formateur.rice), certains classiques (QCM, questions ouvertes ou devoir à compléter par les étudiants, remises de note et commentaire par le.la formateur.rice), certains ludiques (mises en relation, ordonner des réponses, suivre un parcours serious gaming, remise de note … créative ?).

Bref, des outils qui vous permettent de poser des questions et de recevoir des réponses. Mais alors, pourquoi n’utilise-t-on pas d’autres outils comme SurveyMonkey, Jotform ou Google Form ? Finalement, quelle est la différence entre un outil d’enquête et un outil d’évalution si n’est que dans les 2e cas il y a une bonne réponse attendue ?

Bien évaluer : une méthodologie

Shit in. Shit out.

En tout cas, ce n’est pas « juste » poser des questions… cf. le triangle pédagogique. Donc la réponse apportée par ces modules de plateformes ne semble a priori pas répondre au vrai besoin d’une pratique d’évaluation : évaluer des performances à un instant T, évaluer des compétences sur plusieurs instants T.

Si vous voulez vraiment bien évaluer, je ne peux que vous inviter à respecter le cycle de Construction et de Gestion de la Qualité des Tests Standardisés (CGQTS), développés par Jean-Luc Gilles en 2002.

- Analyser & Créer le design : Avant d’évaluer, analysez les 2 autres pilliers du triangle pédagogique. Que voulez-vous évaluer ? Quelles compétences ont été développées pendant la formation et jusqu’à quel niveau taxonomique ? Sur base de cette analyse, désignez votre base de données de questions. Cela vous permettra, lorsque vous créerez un questionnaire, de savoir exactement quels contenus et quelles compétences votre test évaluera.

- Rédiger des questions : Créez et classez vos questions dans cette base de données (DB). Une question, ça ne se crée pas n’importe comment. Elle doit être adaptée à la compétence évaluée, ne comporter aucun biais ni dans son contenu ni dans sa forme. Si vous ajoutez des médias qualitatifs à l’amorce ou aux propositions de votre question, celle-ci se rapproche d’avantage de la réalité des apprenants et vous pouvez supposer un meilleur transfert sur le terrain par après. Qui plus est, pensez à ajouter des réponses générales (aucune réponse correcte, toutes les réponses sont correctes, manque d’information pour répondre, absurdité dans la question), afin de mettre l’évalué dans une position où il ne peut pas mettre en oeuvre des stratégies d’élimination des distracteurs et qu’il ne puisse tenter de répondre avec des calculs de probabilités.

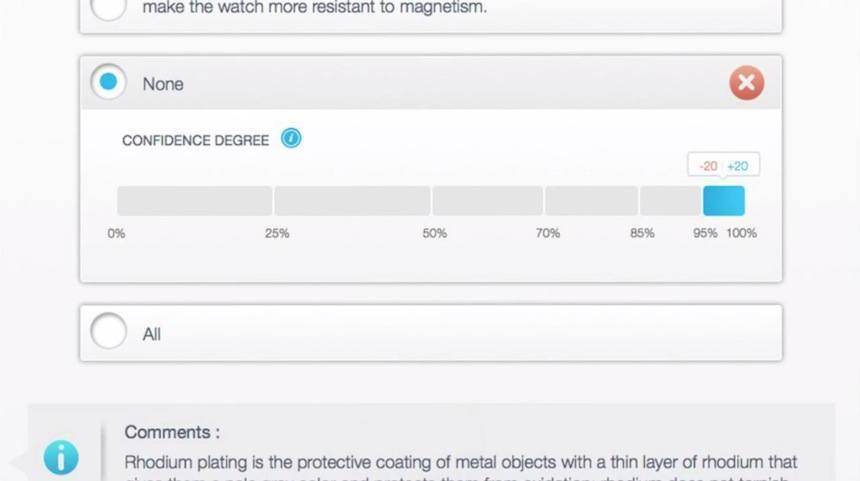

- Créer et paramétrer des questionnaires : Construisez votre questionnaire sur base de votre DB structurée en fonction de vos objectifs et définissez quels barèmes de correction vous allez utiliser. Ah les barèmes … si souvent pris à la légère et pourtant tellement clés pour mesurer efficacement la maîtrise de vos apprenants. Je vous recommande très fortement l’utilisation de degrés de certitude (ne sont pas disponibles sur les modules d’évaluation habituels) ou, à tout le moins le barème anti-hasard, ou for guessing (lui aussi, grand absent des outils d’évaluations). Et s’il vous a semblé indispendable de créer une question ouverte à l’étape précédente, n’oubliez pas de définir une grille de correction critériée, afin de pouvoir la corriger par la suite sur base de faits observables objectifs.

- Organiser les passations : D’abord, rappelez-vous que l’évaluation EST un outil de formation. Elle peut être utilisée à de multiples moments : avant (pré-requis / pré-acquis), pendant (continue / formative), après (formative / certificative). Ainsi, rappelez-vous de prévoir du feedback pour chacune de vos questions si les apprenants se trompent. Ensuite, entraînez vos évalués à utiliser le système de questionnement : il serait regrettable que les performances des apprenants soient biaisées par le stress d’utiliser un système ou une procédure inconnue. Reste à voir quelle technologie vous allez choisir : papier, online, … Cela dépendra bien entendu des ressources à votre disposition.

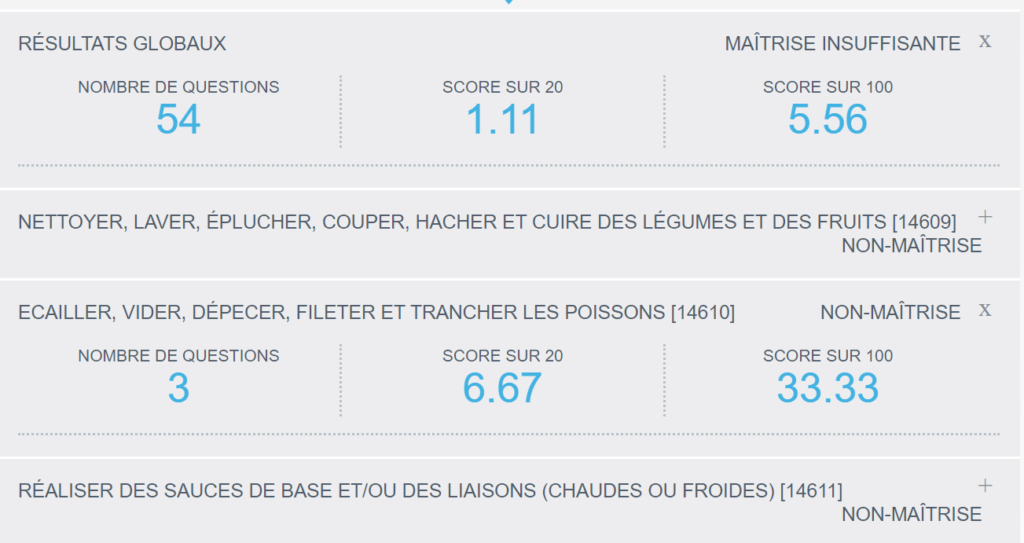

- Donner du feedback : On n’apprend pas de l’expérience… On apprend du feedback sur ses erreurs ! Sur la réponse attendue, sur les résultats globaux, sur les références de contenu qui expliquent une erreur, voire même sur la métacognition de l’apprenant si vous avez utilisé des degrés de certitude (que ce soit un super feedback « tu savais que tu savais » ou un super mauvais feedback « tu ne savais pas que tu ne savais pas » ou entre les deux « tu savais que tu ne savais pas » ou encore « tu ne savais pas que tu savais »).

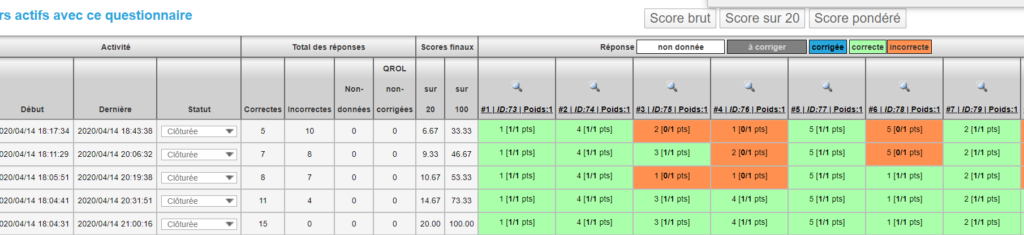

- Réguler, améliorer : Donner du feedback à l’apprenant, c’est bien… Mais quelles conclusions pouvez-vous tirer des résultats ? De nombreuses statistiques peuvent vous donner de l’information sur la qualité de votre test et de vos questions. Les utiliser vous permettra d’évaluer plus justement vos apprenants a posteriori (supprimer une question qui portait à confusion par exemple), mais également d’améliorer votre base de données de questions en continu.

Que faire ?

Avant de faire un choix technologique, la priorité est probablement de repenser la place de l’évaluation dans vos processus de formation.

Une fois que vous savez ce que vous voulez faire et que vous avez établi vos processus, alors demandez-vous « comment ?! ». C’est ici que la technologie rentre en jeu.

Ma conviction profonde, c’est qu’on peut faire des miracles avec des bouts de ficelles… mais qu’on ne peut pas bosser de manière qualitative au quotidien sans vrais outils.

Vous avez dit outils ?

Chacun son job.

Je ne reviens pas là-dessus, un LMS n’est pas l’outil idéal. Alors pourquoi ne pas vous tourner vers un AMS (Assessment Management System) ?

Si la méthodologie que je vous ai décrite ci-dessus, issue de la docimologie (sciences des examens) vous concainc, nous pourrions sans doute en parler d’avantage ?

Je gère aujourd’hui la société ITinera-Group, spin-off de l’Université de Liège qui a mis au point l’AMS Docimo™. Notre plateforme est utilisée tant dans des univeristés et hautes écoles, que dans des grandes organisations publiques et privées, et ce de manière internationale (Europe, Asie, Etats-Unis, Afrique).